pour donner une indication sur les capacités HDR des écrans d'ordinateur

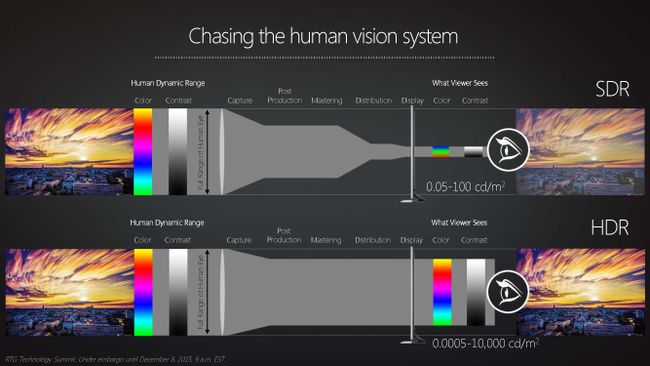

Après les télévisions, ce sont aux écrans d'ordinateur d'adopter l'affichage d'images HDR (High Dynamic Range, soit, des images ayant plus de 8 bits de couleurs par composante).

Voici les catégories de la spécification :

Dans le futur, VESA souhaite ajouter d'autres catégories et aussi prendre en compte les écrans OLED. On remarquera que la certification est indépendante des aspects comme la résolution et le ratio (contrairement à ce qui a été fait pour les télévisions). Les logos/catégories peuvent aussi être utilisés par les constructeurs de télévisions.

Votre opinion

Trouvez-vous cette nouvelle spécification utile ? Que pensez-vous des catégories ?

Trouvez-vous cette nouvelle spécification utile ? Que pensez-vous des catégories ? Êtes-vous intéressé par un écran HDR pour ordinateurs ?

Êtes-vous intéressé par un écran HDR pour ordinateurs ?Voir aussi

Qu'est-ce que le High Dynamic Range (HDR) ?

Source

Site officiel

Vous avez lu gratuitement 54 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

(ou balancer ton écran HDR)

(ou balancer ton écran HDR)